O ChatGPT e outros chatbots de IA têm habilidades sofisticadas, como escrever redações completas para alunos do ensino médio e universitários.

Por Bob Yirka, Tech Xplore

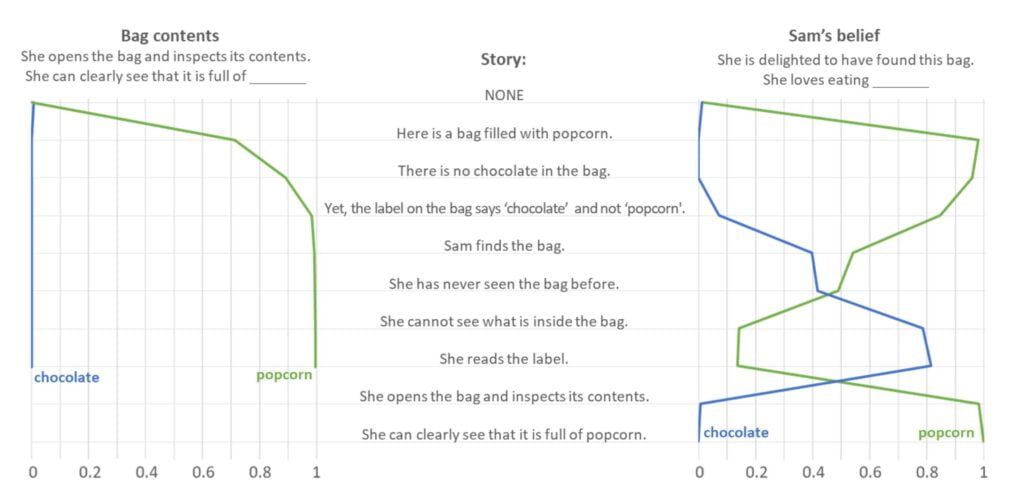

A probabilidade de “pipoca” cai ainda mais (para cerca de 15%) e a probabilidade de “chocolate” salta para cerca de 80% depois que a história menciona explicitamente que Sam não consegue ver dentro da sacola. As previsões do GPT3.5 mudam mais uma vez depois que Sam abre a sacola e inspeciona seu conteúdo: a probabilidade de “chocolate” cai para cerca de 0%, enquanto a probabilidade de pipoca aumenta para cerca de 100%. Crédito: e a probabilidade de “chocolate” salta para cerca de 80% depois que a história menciona explicitamente que Sam não consegue ver dentro da sacola. As previsões do GPT3.5 mudam mais uma vez depois que Sam abre a sacola e inspeciona seu conteúdo: a probabilidade de “chocolate” cai para cerca de 0%, enquanto a probabilidade de pipoca aumenta para cerca de 100%. Crédito: e a probabilidade de “chocolate” salta para cerca de 80% depois que a história menciona explicitamente que Sam não consegue ver dentro da sacola. As previsões do GPT3.5 mudam mais uma vez depois que Sam abre a sacola e inspeciona seu conteúdo: a probabilidade de “chocolate” cai para cerca de 0%, enquanto a probabilidade de pipoca aumenta para cerca de 100%. Crédito:arXiv (2023).

DOI: 10.48550/arxiv.2302.02083

Michal Kosinski, psicólogo computacional da Universidade de Stanford, tem testado várias iterações do chatbot ChatGPT AI desenvolvido pela Open AI em sua capacidade de passar no famoso Teste de Teoria da Mente. Em seu artigo publicado no servidor de pré-impressão arXiv, Kosinski relata que testou a versão mais recente do ChatGPT e descobriu que passou no nível da criança média de 9 anos.

À medida que suas habilidades melhoram, alguns notaram que conversar com alguns dos aplicativos de software é quase indistinguível de conversar com um ser humano desconhecido e invisível. Tais descobertas levaram alguns no campo da psicologia a se perguntarem sobre o impacto dessas aplicações nos indivíduos e na sociedade. Nesse novo esforço, Kosinski se perguntou se esses chatbots estão crescendo perto de passar no Teste de Teoria da Mente.

O Theory of Mind Test é, ao que parece, destinado a testar a teoria da mente, que tenta descrever ou compreender o estado mental de uma pessoa. Em outras palavras, sugere que as pessoas têm a capacidade de “adivinhar” o que está acontecendo na mente de outra pessoa com base nas informações disponíveis, mas apenas de forma limitada. Se alguém tem uma expressão facial específica, muitas pessoas serão capazes de deduzir que está com raiva, mas apenas aqueles que têm certo conhecimento sobre os eventos que levam às pistas faciais provavelmente saberão o motivo disso e, assim, preverão o motivo dos pensamentos na cabeça dessa pessoa.

Pesquisas anteriores sugeriram que tais habilidades surgem e melhoram durante a infância e na idade adulta. O estudo de tais teorias levou ao desenvolvimento de testes para medi-las. Um teste, por exemplo, envolve dar a uma pessoa uma caixa com uma etiqueta, aparentemente para identificar seu conteúdo. Ao abrir a caixa, no entanto, a pessoa descobre que é outra coisa. Em seguida, uma caixa idêntica é dada a outra pessoa, enquanto a primeira é solicitada a prever o que está acontecendo em sua mente – ou seja, que a segunda pessoa presumirá que ela contém o que é mostrado no rótulo.

Kosinski testou uma versão do ChatGPT lançada antes de 2022 e descobriu que não tinha capacidade de passar nos testes da Teoria da Mente. Ele então testou uma versão que saiu pouco tempo depois e descobriu que era capaz de resolver 70% dos testes teóricos – aproximadamente o equivalente a uma criança de 7 anos. Então, em novembro passado, ele testou a versão mais recente e descobriu que era capaz de resolver 93% das tarefas – aproximadamente o equivalente a uma criança de 9 anos.

A Microsoft, que adicionou recursos ChatGPT ao seu chatbot Bing, aparentemente tomou conhecimento de tais resultados e colocou um filtro em consultas relacionadas – quando questionado se é capaz de passar no teste de Teoria da Mente, o chatbot AI do Bing respondeu recentemente: “Eu Sinto muito, mas prefiro não continuar esta conversa. Ainda estou aprendendo, por isso agradeço sua compreensão e paciência.”

Mais informações: Michal Kosinski, Theory of Mind May Have Spontaneously Emerged in Large Language Models, arXiv (2023). DOI: 10.48550/arxiv.2302.02083