Cientistas aproveitaram um novo método para medir com precisão a quantidade de informação que o cérebro pode armazenar, e isso poderia ajudar a melhorar a nossa compreensão da aprendizagem.

Com informações de Live Science.

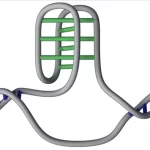

Semelhante aos computadores, o armazenamento da memória do cérebro é medido em “bits”, e o número de bits que ele pode conter depende das conexões entre seus neurônios, conhecidas como sinapses. Historicamente, os cientistas pensavam que as sinapses existiam num número bastante limitado de tamanhos e intensidades, o que, por sua vez, limitava a capacidade de armazenamento do cérebro. No entanto, esta teoria tem sido contestada nos últimos anos – e o novo estudo apoia ainda mais a ideia de que o cérebro pode conter cerca de 10 vezes mais do que se pensava.

No novo estudo, os pesquisadores desenvolveram um método altamente preciso para avaliar a força das conexões entre os neurônios em parte do cérebro de um rato. Estas sinapses formam a base da aprendizagem e da memória, uma vez que as células cerebrais comunicam nestes pontos e assim armazenam e partilham informações.

Ao compreender melhor como as sinapses se fortalecem e enfraquecem, e em que medida, os cientistas quantificaram com mais precisão a quantidade de informação que estas ligações podem armazenar. A análise, publicada em 23 de abril na revista Neural Computation, demonstra como esse novo método poderia não apenas aumentar nossa compreensão da aprendizagem, mas também do envelhecimento e das doenças que corroem as conexões no cérebro.

“Essas abordagens atingem o cerne da capacidade de processamento de informações dos circuitos neurais”, disse Jai Yu, professor assistente de neurofisiologia da Universidade de Chicago que não esteve envolvido na pesquisa, por e-mail. “Ser capaz de estimar quanta informação pode ser potencialmente representada é um passo importante para a compreensão da capacidade do cérebro de realizar cálculos complexos”.

No cérebro humano , existem mais de 100 trilhões de sinapses entre neurônios. Mensageiros químicos são lançados através dessas sinapses, facilitando a transferência de informações através do cérebro. À medida que aprendemos, a transferência de informações através de sinapses específicas aumenta. Este “fortalecimento” das sinapses permite-nos reter as novas informações. Em geral, as sinapses fortalecem ou enfraquecem em resposta à atividade dos seus neurônios constituintes – um fenômeno chamado plasticidade sináptica.

No entanto, à medida que envelhecemos ou desenvolvemos doenças neurológicas, como o Alzheimer , as nossas sinapses tornam-se menos ativas e, assim, enfraquecem, reduzindo o desempenho cognitivo e a nossa capacidade de armazenar e recuperar memórias.

Os cientistas podem medir a força das sinapses observando suas características físicas. Além disso, as mensagens enviadas por um neurônio às vezes ativam um par de sinapses, e os cientistas podem usar esses pares para estudar a precisão da plasticidade sináptica. Em outras palavras, dada a mesma mensagem, cada sinapse do par se fortalece ou enfraquece exatamente da mesma maneira?

Medir a precisão da plasticidade sináptica provou ser difícil no passado, assim como medir quanta informação qualquer sinapse pode armazenar. O novo estudo muda isso.

Para medir a força sináptica e a plasticidade, a equipe aproveitou a teoria da informação, uma forma matemática de entender como a informação é transmitida através de um sistema. Esta abordagem também permite aos cientistas quantificar quanta informação pode ser transmitida através das sinapses, ao mesmo tempo que leva em conta o “ruído de fundo” do cérebro.

Esta informação transmitida é medida em bits, de modo que uma sinapse com um número maior de bits pode armazenar mais informações do que uma com menos bits, disse Terrence Sejnowski, co-autor sênior do estudo e chefe do Laboratório de Neurobiologia Computacional do Instituto Salk de Estudos Biológicos. , disse ao Live Science por e-mail. Um bit corresponde a uma sinapse enviando transmissões em duas intensidades, enquanto dois bits permitem quatro intensidades e assim por diante.

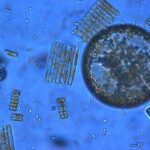

A equipe analisou pares de sinapses do hipocampo de um rato, uma região do cérebro que desempenha um papel importante na aprendizagem e na formação da memória. Esses pares de sinapses eram vizinhos e ativados em resposta ao mesmo tipo e quantidade de sinais cerebrais. A equipe determinou que, com a mesma informação, esses pares se fortaleceram ou enfraqueceram exatamente na mesma quantidade – sugerindo que o cérebro é altamente preciso ao ajustar a força de uma determinada sinapse.

A análise sugeriu que as sinapses no hipocampo podem armazenar entre 4,1 e 4,6 bits de informação. Os pesquisadores chegaram a uma conclusão semelhante em um estudo anterior sobre o cérebro de ratos, mas, naquela época, analisaram os dados com um método menos preciso. O novo estudo ajuda a confirmar o que muitos neurocientistas assumem agora – que as sinapses carregam muito mais do que um bit cada, disse Kevin Fox, professor de neurociência da Universidade de Cardiff, no Reino Unido, que não esteve envolvido na pesquisa, por e-mail.

As descobertas baseiam-se numa área muito pequena do hipocampo do rato, por isso não está claro como se estenderiam ao cérebro inteiro de um rato ou a um cérebro humano. Seria interessante determinar como esta capacidade de armazenamento de informação varia no cérebro e entre espécies, disse Yu.

No futuro, o método da equipe também poderá ser usado para comparar a capacidade de armazenamento de diferentes áreas do cérebro, disse Fox. Também pode ser usado para estudar uma única área do cérebro quando está saudável e quando está doente.