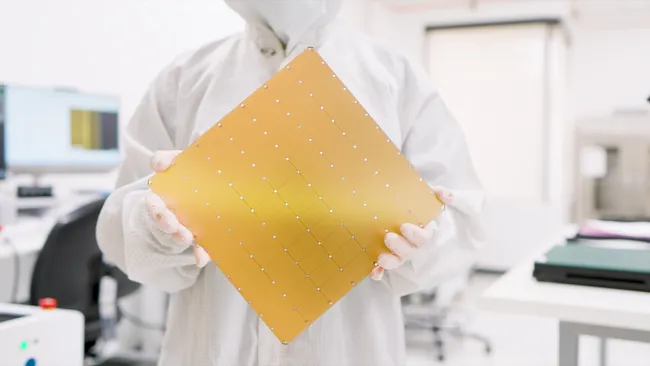

O chip Wafer Scale Engine 3 (WSE-3) da Cerebras contém quatro trilhões de transistores e um dia alimentará o supercomputador Condor Galaxy 3 de 8 exaFLOP.

Com informações de Live Science.

Os cientistas construíram o maior chip de computador do mundo – um gigante repleto de 4 trilhões de transistores. O enorme chip um dia será usado para operar um supercomputador de inteligência artificial (IA) monstruosamente poderoso, dizem seus fabricantes.

O novo Wafer Scale Engine 3 (WSE-3) é a terceira geração da plataforma da empresa de supercomputação Cerebras projetada para alimentar sistemas de IA, como o GPT-4 da OpenAI e o Claude 3 Opus da Anthropic.

O chip, que inclui 900.000 núcleos de IA, é composto por um wafer de silício medindo 8,5 por 8,5 polegadas (21,5 por 21,5 centímetros) – assim como seu antecessor de 2021, o WSE-2.

O novo chip usa a mesma quantidade de energia que seu antecessor, mas é duas vezes mais poderoso, disseram representantes da empresa em comunicado à imprensa. O chip anterior, por outro lado, incluía 2,6 trilhões de transistores e 850 mil núcleos de IA – o que significa que a empresa aderiu aproximadamente à Lei de Moore, que afirma que o número de transistores em um chip de computador praticamente dobra a cada dois anos.

Em comparação, um dos chips mais poderosos usados atualmente para treinar modelos de IA é a unidade de processamento gráfico (GPU) Nvidia H200. Mesmo assim, a GPU monstruosa da Nvidia tem insignificantes 80 bilhões de transistores, 57 vezes menos que a da Cerebras.

O chip WSE-3 será um dia usado para alimentar o supercomputador Condor Galaxy 3, que terá sede em Dallas, Texas, disseram representantes da empresa em comunicado separado divulgado em 13 de março.

O supercomputador Condor Galaxy 3, que está em construção, será composto por 64 “blocos de construção” do sistema Cerebras CS-3 AI que são alimentados pelo chip WSE-3. Quando costurado e ativado, todo o sistema produzirá 8 exaFLOPs de poder computacional.

Então, quando combinada com os sistemas Condor Galaxy 1 e Condor Galaxy 2, toda a rede atingirá um total de 16 exaFLOPs.

(Operações de ponto flutuante por segundo (FLOPs) é uma medida que calcula o desempenho de computação numérica de um sistema – onde 1 exaFLOP é um quintilhão (1.018) FLOPs.)

Por outro lado, o supercomputador mais poderoso do mundo atualmente é o supercomputador Frontier do Oak Ridge National Laboratory, que gera aproximadamente 1 exaFLOP de energia.

O supercomputador Condor Galaxy 3 será usado para treinar futuros sistemas de IA que serão até 10 vezes maiores que o GPT-4 ou o Gemini do Google, disseram representantes da empresa. O GPT-4, por exemplo, usa cerca de 1,76 trilhão de variáveis (conhecidas como parâmetros) para treinar o sistema, de acordo com rumores de vazamento; o Condor Galaxy 3 poderia lidar com sistemas de IA com cerca de 24 trilhões de parâmetros.